Requirement clarification

我需要分析用户的需求,理解他们想要了解的"data dependent的逐层可跳过的模型结构设计"相关文献。

首先,我需要了解用户提供的论文链接内容,以便更准确地理解用户的研究方向。这篇论文似乎是关于一种可以根据数据特性动态调整计算路径的神经网络架构。我需要搜索相关文献来回应用户的请求。

Search

arxiv 2509.00925 data dependent layer skipping neural network architecture基于用户提供的链接和搜索结果,我理解用户想了解类似于arxiv:2509.00925论文中"data dependent的逐层可跳过的模型结构设计"的相关研究工作。这类研究主要关注如何根据输入数据特性动态调整神经网络的计算路径,以提高推理效率。

从搜索结果中,我发现了一篇相关性很高的论文LayerSkip (arXiv:2404.16710),它提出了一种端到端解决方案,通过层dropout训练和早期退出机制来加速大型语言模型的推理。这与用户提到的"data dependent的逐层可跳过"技术相似。

为了更全面地回应用户需求,我需要了解用户对这类技术的具体关注点,以便提供更有针对性的文献分析。

- 您是否特别关注某个特定领域(如NLP、CV、推荐系统等)中的动态计算路径技术?

- 您更关注这类技术的理论基础,还是实际应用和性能提升?

- 您是否需要包含最新(2025年)的研究进展,或者经典的奠基性工作也感兴趣?

好的,这是一个为您制定的研究计划。

- 明确“data-dependent”和“逐层可跳过”这两个核心技术概念,并提炼出如“dynamic networks”、“conditional computation”、“early exit”、“adaptive inference”等相关的同义词和关键词,以扩大检索范围。

- 在Google Scholar、arXiv、Semantic Scholar等学术搜索引擎中,使用上述关键词组合进行检索,初步筛选出一批与主题高度相关的研究论文。

- 分析已筛选论文的“Related Work”章节和参考文献,追溯该领域的奠基性、开创性工作,并利用引文网络向前追溯引用这些经典论文的最新研究进展。

- 针对每篇筛选出的核心论文,深入分析其提出的模型结构、决策机制(如何判断是否跳层)、适用的任务领域(如CV、NLP)以及实验验证的性能(如加速比、精度损失)。

- 对不同的技术路径进行归类和比较,例如区分是基于强化学习、门控机制还是其他方法实现的动态计算,并分析各自的优缺点和适用场景。

- 综合所有信息,整理并输出一份结构化的报告,将论文按照技术流派或发展时间线进行分类,并对每篇论文的核心思想、创新点和实验效果进行简要评述。

Deep Research

首先,我需要了解您提供的论文链接中的内容,以便更好地理解您所指的"data dependent的逐层可跳过的模型结构设计"。

摘要

本论文介绍了DTRNet(Dynamic Token Routing Network),一种改进的Transformer架构,旨在减少Transformer中二次方复杂度的计算成本。DTRNet允许令牌动态跳过跨令牌混合的二次方成本,同时仍接收轻量级的线性更新。通过保留MLP模块并将大多数令牌的注意力成本降低为线性,DTRNet确保每个令牌都得到明确更新,同时显著降低整体计算量。经训练后,DTRNet在每层仅将10%的令牌路由通过注意力机制,同时保持与完整Transformer相当的性能。它在相同FLOP条件下,在准确性和内存方面始终优于基于路由的层跳过方法(如MoD和D-LLM),同时路由更少的令牌到完整注意力层。其效率随序列长度增加而提高,为长上下文输入提供显著的FLOP减少。通过将令牌更新与注意力混合解耦,DTRNet大幅减少了计算中的二次方部分,为Transformer提供了一种简单、高效且可扩展的替代方案。

与问题相关的信息提取

这篇论文题为"DTRNet: Dynamic Token Routing Network to Reduce Quadratic Costs in Transformers",由Aman Sharma、Saeed Najafi、Parsa Farinneya等多位来自华为诺亚方舟实验室、阿尔伯塔大学、滑铁卢大学和AMD的研究人员共同完成。

论文的主要贡献是提出了一种名为DTRNet的动态令牌路由网络,旨在解决Transformer模型中自注意力机制的二次方复杂度问题。具体贡献包括:

-

提出了一种动态路由架构,通过轻量级线性路径和二次方注意力路径实现显式令牌更新,同时保留共享MLP块,从而降低计算成本。

-

设计了一个简单的训练目标,通过惩罚将令牌路由到注意力机制的行为,使模型能够学习何时需要注意力,同时保持准确性。

-

实证分析表明,DTRNet在可比较的计算量下优于现有最先进的方法,并在不同模型规模(360M, 1.3B)上提高效率。评估显示DTRNet的效率和FLOP增益随序列长度增加而增加,超过密集Transformer和先前的路由方法。

DTRNet的核心创新在于其数据依赖的逐层可跳过模型结构:

-

双路径设计:在每一层,学习型路由器将每个令牌分配到两条路径之一:

- 二次方路径:标准的全注意力路径,进行跨令牌混合

- 线性路径:轻量级路径,通过共享的值和输出投影更新令牌,跳过昂贵的注意力计算

-

令牌路由器:使用两层前馈网络决定每个令牌应该走哪条路径,生成软路由分数,在推理时执行硬路由。

-

保留MLP更新:与之前的方法不同,DTRNet对所有令牌都保留MLP模块,确保即使跳过注意力计算的令牌也能得到有意义的更新。

-

稀疏注意力等效性:硬路由方案产生动态稀疏注意力机制,限制注意力只在被路由到注意力路径的令牌之间进行交互。

-

训练和正则化:使用复合损失函数,包括任务交叉熵损失和注意力使用惩罚项,鼓励稀疏、预算感知的注意力使用。

实验表明,DTRNet在每层平均只将约10%的令牌路由通过注意力机制,同时保持与完整Transformer相当的性能,在相同FLOP条件下,在准确性和内存方面始终优于基于路由的层跳过方法。

相关网页链接

论文中提到了一个代码链接:

- "The code is released at https://github.com/Aman26Sharma/DTRNet" - 这是论文作者发布的DTRNet实现代码库

相关图片提取

-

图片标题: Layer-wise Hidden State Cosine Similarity

内容: 展示了1.3B SmolLM模型中令牌嵌入的平均层间余弦相似度热力图

来源: 论文作者

链接: 未知(论文中的Figure 1) -

图片标题: DTRNet Layer

内容: 展示了DTRNet层的结构图,左侧是路由到自注意力路径的令牌流程,右侧是路由到仅投影(bypass)路径的令牌流程

来源: 论文作者

链接: 未知(论文中的Figure 2)

感谢您提供的信息。现在我对DTRNet这篇论文有了基本了解,它是一种数据依赖的逐层可跳过模型结构设计,主要通过动态令牌路由来减少Transformer中的二次方计算成本。接下来,我将搜索类似的研究工作。

Search

data dependent skip layer dynamic network transformer "early exit" "conditional computation"现在我对"data dependent的逐层可跳过的模型结构设计"相关研究有了初步了解。我需要进一步搜索更多相关论文,特别是与DTRNet类似的动态网络结构。

Search

dynamic networks transformer "early exit" "conditional computation" "adaptive inference" "token routing"我需要继续搜索更多关于动态网络和条件计算的相关研究,特别是与DTRNet类似的模型结构。

Search

dynamic token routing skip layer transformer MoE early exit conditional computation已掌握的信息

- 核心论文理解:已深入分析了用户提供的论文DTRNet,明确了其核心思想是通过动态令牌路由(Dynamic Token Routing)机制,让每个令牌(token)在每一层动态选择执行完整的二次方复杂度注意力计算,还是执行一个轻量级的线性更新,从而在数据依赖(data-dependent)的层面节省计算资源。

- 关键技术流派识别:通过初步检索,已识别出与该主题相关的几个主要技术方向。这包括以DTRNet和Mixture-of-Depths (MoD)为代表的令牌级动态计算(token-level dynamic computation),它们在每层决定哪些令牌需要更多计算;以“Learning to Skip the Middle Layers of Transformers”为代表的层级跳过(layer skipping),它们决定跳过整个中间层;以及更广义的提前退出(early exit)机制,它们在样本层面决定何时终止整个推断过程。

- 重要相关论文发掘:已经发现了几篇高度相关的研究论文,如Mixture-of-Depths (MoD)、Mixture-of-Recursions (MoR)等,它们与DTRNet一样,都采用了某种形式的路由机制来动态分配计算资源。同时,也找到了相关的综述性文章,为构建该领域的技术图谱提供了宏观视角。

- 核心概念关联:明确了“条件计算”(Conditional Computation)和“混合专家模型”(Mixture-of-Experts, MoE)是该领域的重要理论基础。特别是MoE中的路由(routing)思想,被广泛借鉴用于实现动态的网络结构。

下一步行动计划

- 系统性论文分析:将对已识别的核心论文(如DTRNet, MoD, MoR, "Skip Middle Layers"等)进行逐一精读和深度解析。重点提炼每种方法的核心机制(决策模块如何设计、路由策略是什么)、性能权衡(在节省多少计算量的同时,模型性能如何变化)、以及各自的优缺点和适用场景。主要信息来源为arXiv、Google Scholar等学术数据库上的论文原文。

- 构建技术分类框架:基于已掌握的信息,建立一个清晰的分类体系来组织这些动态模型结构。可以从“动态调整的粒度”(例如:令牌级、层级、样本级)和“决策机制的类型”(例如:基于门控、基于强化学习、基于固定预算)等维度进行划分,并为每个类别填充代表性的研究工作。

- 进行横向对比与可视化:创建一个对比矩阵或思维导图,系统性地比较不同方法在模型结构、路由算法、训练目标、计算效率提升和性能损失等关键指标上的异同。利用可视化工具将这些对比结果以图表形式呈现,使不同技术路径的特点和权衡一目了然。

- 梳理技术演进脉络:通过分析关键论文的引文网络,追溯该领域的发展历史和关键的开创性工作。明确各项技术是如何在前人工作的基础上演进的,例如从MoE的专家选择,发展到DTRNet和MoD的计算路径选择。这将为最终报告构建一个有深度、有逻辑的叙事结构。

- 整合信息并撰写报告:最后,将所有分析和对比结果整合成一份结构完整、逻辑清晰、图文并茂的研究报告。报告将首先介绍背景问题,然后分章节阐述不同的技术流派,并附上详细的案例分析和横向对比,最后对该研究方向的现状进行总结,并展望未来的发展趋势。

首先,我需要更深入地了解一些关键论文,特别是MoD和"Skip Middle Layers"这两篇与DTRNet高度相关的工作。

看来访问这个URL遇到了问题。我将尝试搜索更多关于Mixture-of-Depths (MoD)的信息。

Search

Mixture-of-Depths MoD transformer dynamic layer skipping paper我需要继续搜索更多关于"Learning to Skip the Middle Layers of Transformers"这篇论文的信息,以及其他相关的动态网络结构设计。

Search

Learning to Skip the Middle Layers of Transformers paper details我需要进一步了解DTRNet论文的详细内容,以便更好地理解其技术方法和与其他动态网络结构的异同。

Search

DTRNet Dynamic Token Routing Network to Reduce Quadratic Costs in Transformers已掌握的信息

- 核心论文(DTRNet)分析: 已经深入理解了DTRNet的核心机制,即在Transformer的每一层,通过一个动态令牌路由器(Dynamic Token Router)决定每个令牌(token)是进入计算量大的自注意力路径,还是进入一个轻量级的线性更新路径,从而实现数据依赖的计算量节省。

- 关键技术流派识别: 已识别出与DTRNet思想类似但实现方式不同的几个主要技术方向。一类是令牌级动态计算,如Mixture-of-Depths (MoD),它为每层设定一个固定的计算容量(token数量),通过路由机制选择最重要的令牌进行计算,其余的则直接跳过。另一类是层级动态计算,如“Learning to Skip the Middle Layers of Transformers”,它根据输入动态地决定是否跳过整个中间层块。

- 核心概念关联: 明确了这些动态结构都属于“条件计算”(Conditional Computation)的范畴,其核心思想是根据输入样本的特性自适应地调整计算路径和计算量。这种思想与“混合专家模型”(Mixture-of-Experts, MoE)中的路由机制一脉相承。

- 重要相关论文发掘: 已经定位了多篇与用户任务高度相关的关键论文,包括《Mixture-of-Depths: Dynamically allocating compute in transformer-based language models》和《Learning to Skip the Middle Layers of Transformers》,为接下来的深度分析和比较奠定了基础。

下一步行动计划

- 系统性论文精读与信息提取: 将对已识别的核心论文(DTRNet, MoD, "Skip Middle Layers"等)进行逐一的深度解析。重点关注并提取每种方法在以下几个方面的具体实现细节:

- 决策机制:用于判断“是否跳过”或“走哪条路”的模块是如何设计的(例如,是小型神经网络还是其他机制)?其决策依据是什么?

- 训练策略:模型是如何被训练以学会进行有效决策的?是否引入了特定的辅助损失函数来鼓励稀疏性或跳过行为?

- 模型结构:当一个计算单元(层或令牌)被“跳过”时,信息是如何流动的(例如,是通过简单的残差连接,还是有专门的轻量级处理路径)?

- 性能权衡:在节省了多少计算资源(如FLOPs)的同时,对模型最终性能(如准确率、困惑度)造成了多大影响?

这些详细信息将主要通过查阅arXiv、Google Scholar等学术平台上的论文原文来获取。

- 构建技术分类与对比框架: 基于精读所获得的信息,建立一个清晰的分类体系来梳理这些动态网络结构。将从“动态调整的粒度”(令牌级 vs. 层级)和“实现机制”(路由 vs. 门控)等维度对不同方法进行归类,并设计一个多维度对比表格,系统性地比较它们在核心思想、优缺点、适用场景等方面的异同。

- 技术演进脉络梳理: 通过分析关键论文的引言和相关工作部分,追溯该领域的技术发展脉络。重点梳理这些动态跳层结构是如何从更早期的工作(如传统的Early Exit、Mixture-of-Experts)演化而来的,以理解其技术传承与创新。

- 整合信息并生成结构化报告: 将所有分析结果、分类框架和对比表格进行整合,最终形成一份逻辑清晰、图文并茂的综合性研究报告。报告将以问题背景为切入点,分章节详细阐述不同技术流派的代表性工作,并附上直观的对比分析图表,最后对该研究方向的整体趋势进行总结和展望。

现在,我需要更深入地了解DTRNet的具体实现细节,以便与其他方法进行比较。

1. 网页内容摘要

这个网页是DTRNet(Dynamic Token Routing Network)项目的GitHub仓库主页。DTRNet是一种改进的Transformer架构,旨在减少Transformer中的二次方计算成本。传统Transformer在每一层对每个token都应用二次方复杂度的自注意力机制,计算开销大。DTRNet通过动态令牌路由机制,允许tokens跳过跨token混合的二次方成本,同时仍接收轻量级的线性更新。

核心创新点在于:DTRNet分析发现内层token嵌入在相邻层之间变化很小,表明存在计算冗余。通过保留MLP模块并将大多数token的注意力成本降低为线性,DTRNet确保每个token都得到显式更新,同时显著降低整体计算量。训练后,DTRNet在每层仅将约10%的tokens路由通过注意力机制,同时保持与完整Transformer相当的性能。

该项目基于Hugging Face Transformers库实现,支持LLaMA和SmolLM模型系列,提供了DeepSpeed Zero-3/PyTorch DDP优化、基于YAML的配置系统、Weights & Biases集成等功能。仓库包含完整的代码结构、安装指南、训练和评估方法说明。

2. 与DTRNet网络结构、路由机制和训练方法相关的信息

DTRNet(Dynamic Token Routing Network)是一种改进的Transformer架构,专门设计用于减少Transformer中的二次方计算成本。以下是关于其网络结构、路由机制和训练方法的详细信息:

网络结构:

- DTRNet保留了传统Transformer的基本结构,但引入了双路径设计:注意力路径和投影路径(绕行路径)

- 注意力路径:tokens经过完整的跨token混合(传统的自注意力机制)

- 投影路径(绕行路径):tokens跳过混合,通过值投影(W_V)和输出投影(W_O)接收token本地更新,然后通过共享的前馈网络(FFN)

- 两条路径共享参数,确保模型一致性

- 关键创新点是保留了MLP模块,确保即使跳过注意力机制,每个token仍然接收有意义的更新

- 与标准Transformer不同,DTRNet不是完全跳过某些层,而是在每层内部实现动态路由

路由机制:

- DTRNet实现了动态token路由,决定哪些tokens需要完整的注意力计算,哪些可以走轻量级的线性路径

- 路由决策基于token嵌入在相邻层之间的变化程度,发现许多tokens在层间变化很小,表明存在计算冗余

- 训练完成后,DTRNet在每一层仅将约10%的tokens路由通过注意力机制,其余90%走线性路径

- 这种路由机制使计算效率随序列长度增加而提高,对长上下文输入特别有效

- 路由决策是动态的,基于输入内容,而不是预定义的静态路径

训练方法:

- DTRNet使用Hugging Face Transformers库实现,支持LLaMA和SmolLM模型系列

- 训练实验主要在SmolLM-360M上进行

- 使用DeepSpeed Zero-3或PyTorch DDP进行分布式训练优化

- 通过YAML配置文件设置实验参数,包括基础模型配置、DTRNet层放置位置和训练超参数

- 集成了Weights & Biases进行实验跟踪

- 使用lm-evaluation-harness评估下游任务性能

- 训练过程中,模型学习如何有效地路由tokens,在保持性能的同时减少计算

DTRNet的核心优势在于将token更新与注意力混合解耦,大幅减少了计算中的二次方部分,提供了一种简单、高效且可扩展的Transformer替代方案。通过这种方式,DTRNet在维持模型性能的同时,显著降低了计算复杂度,特别适合处理长序列输入。

3. 相关网页链接

-

论文链接 - 上下文:DTRNet: Dynamic Token Routing Network to Reduce Quadratic Costs in Transformers 论文

-

代码仓库 - 上下文:DTRNet项目的GitHub代码仓库

-

DTRNet架构图 - 上下文:展示DTRNet层结构的图片,左侧是自注意力路径,右侧是投影路径

-

Hugging Face Transformers库 - 上下文:DTRNet实现所基于的核心模型和训练框架

-

DeepSpeed - 上下文:用于高效分布式训练和内存优化(ZeRO-3)

-

FlashAttention - 上下文:DTRNet实现中使用的优化注意力计算方法

-

FlashAttention论文 - 上下文:优化注意力计算的相关研究

-

TRL Experiments - 上下文:提供DTRNet基于的训练流水线结构

-

lm-evaluation-harness - 上下文:用于下游任务的标准化评估

-

LICENSE - 上下文:项目的Apache License 2.0许可证文件

4. 相关图片

- DTRNet架构图

- Title: DTRNet Architecture

- Content: 展示了DTRNet层的结构。左侧是自注意力路径,tokens经过完整的跨token混合;右侧是投影路径(bypass),tokens跳过混合,通过值投影(W_V)和输出投影(W_O)接收更新,然后经过共享的前馈网络(FFN)。两条路径共享参数。

- Source: Aman26Sharma/DTRNet

- Link: https://github.com/Aman26Sharma/DTRNet/raw/main/assets/DTRNet_arch.jpg

我需要进一步了解Mixture-of-Depths (MoD)的具体实现细节,以便与DTRNet进行比较。

Search

Mixture-of-Depths MoD transformer paper implementation details现在我需要了解"Learning to Skip the Middle Layers of Transformers"这篇论文的详细内容,以便与DTRNet和MoD进行比较。

网页内容摘要

这篇论文《Learning to Skip the Middle Layers of Transformers》提出了一种新型Transformer架构,能够动态跳过中间层以提高计算效率。研究受到可解释性研究的启发,这些研究表明Transformer的中间层冗余度更高,而早期层则负责将信息聚合到token位置。作者设计了一种学习型门控机制,可以基于输入决定是否绕过中心区块,并使用门控注意力机制防止后续token关注被跳过的token位置。

该架构的核心思想是从中间向外跳过变量数量的层,对于"简单"的输入分配更少的计算资源。门控机制为每个token位置和模型前半部分的每个块计算一个标量门值,当门值为零时,该token会跳过从该层到对称层之间的所有Transformer块。作者还引入了"sandwich"或"peri-layernorm"方案来控制残差范数,并使用自适应正则化损失控制门值稀疏性。

然而,在作者研究的规模下,与具有更少层的密集基线相比,该方法在验证交叉熵和估计FLOP之间的权衡方面没有实现改进。作者已在GitHub上发布了代码。

与问题相关的信息提取

这篇论文提出了一种新型Transformer架构,其核心思想是动态跳过中间层以提高计算效率。以下是详细分析:

核心思想:

- 基于可解释性研究的发现,Transformer的中间层表现出更大的冗余性,而早期层负责将信息聚合到token位置。

- 提出从"中间向外"动态跳过变量数量的层,而不是像现有方法那样独立跳过各层或针对单个模块。

- 对于"简单"的输入分配更少的计算资源,通过跳过更可能冗余的中间层。

- 尝试形成一个多层次的表示层次结构,中心层处理的token越少,允许表示层次的自然涌现。

网络结构:

- 门控机制:为模型前半部分的每个块引入一个线性层,输出一个标量软掩码值,当累积的软掩码值≥1时,跳过处理该token位置的Transformer块。

- 门控注意力:当token的门值为零时,防止后续token在注意力模块中关注该被门控的token。

- 层归一化:使用"sandwich"或"peri-layernorm"方案,在注意力和FFN模块的残差输入和输出上都应用层归一化操作。

- 稀疏性控制:引入基于门值的均值和方差的正则化损失,使用自适应系数根据与层级目标的偏差按比例更新。

实验结果:

- 在没有控制门值稀疏性的情况下,平均稀疏性趋向于零,门控模型表现与密集基线相似。

- 随着最终目标μ*L/2从1降至0,稀疏性增加,估计的FLOP减少。

- 然而,在作者研究的规模下,与具有更少层的密集基线相比,所提出的架构并没有改善交叉熵。

- 作者在FineWeb数据集上进行了预训练评估,使用了基于Llama 3的Transformer模型,维度类似于GPT-2 small。

- 实验使用AdamW优化器,线性预热和余弦衰减,在4个NVIDIA A100或GH200 GPU上进行训练。

尽管理论上有潜力,但在当前研究规模下,该方法在计算效率和性能之间的权衡方面未能超越传统密集模型。

相关网页链接

-

https://github.com/tim-lawson/skip-middle - 作者发布的代码仓库链接,上下文为"We release our code at https://github.com/tim-lawson/skip-middle."

-

https://arxiv.org/abs/2506.21103v1 - 论文的arXiv链接(从页面顶部推断)

相关图片提取

-

图片标题: Figure 1: An illustration of our proposed architecture

内容: 展示了提出的架构(有四层或块)。为模型前半部分的每个token位置和块计算一个标量门值。如果块ℓ的门值为零,则跳过该token的ℓ和L-ℓ之间的Transformer块,并防止其他token在相应的自注意力模块中关注其位置。

来源: Tim Lawson和Laurence Aitchison(论文作者)

链接: 未知 -

图片标题: Figure 2: Performance comparisons

内容: 比较门控Transformer架构与基线模型(2至12层)的性能。所有带控制的门控模型都是12层架构的变体。测量了FineWeb验证集上100M个token的交叉熵。单次前向传递的估计FLOP假设从验证集上门值的最终稀疏性中获得最大计算收益。

来源: Tim Lawson和Laurence Aitchison(论文作者)

链接: 未知 -

图片标题: Table 1: Alternative techniques to control the sparsity of the gate values

内容: 展示了控制门值稀疏性的替代技术,包括sparsity、sparsity_variance、adaptive、proportional和sparsity_variance_l2等方法及其损失函数和更新规则。

来源: Tim Lawson和Laurence Aitchison(论文作者)

链接: 未知 -

图片标题: Table 2: Default hyperparameters

内容: 列出了实验中使用的默认超参数,包括模型维度、层数、头数、词汇表大小等模型参数,以及批量大小、学习率、优化器参数等训练参数。

来源: Tim Lawson和Laurence Aitchison(论文作者)

链接: 未知

我现在需要了解更多关于"Learning to Skip the Middle Layers of Transformers"的实现细节,以便与DTRNet和MoD进行更深入的比较。

摘要

"Learning to Skip the Middle Layers of Transformers"是一个开源项目,旨在实现一种能够动态跳过Transformer模型中间层的技术。该项目基于Meta的Llama 3模型实现,但采用了Sandwich-LN(又称Peri-LN)架构而非Pre-LN。项目代码库基于"nanoGPT speedrun",提供了完整的训练流程,包括数据下载、模型训练等功能。项目使用FineWeb数据集进行训练,支持单机和分布式训练方式。代码实现采用Python语言,并提供了详细的安装指南,包括使用uv工具创建虚拟环境和安装依赖包。该项目已在GitHub上开源,使用MIT许可证,并在arXiv上发布了相关论文(arxiv.org/abs/2506.21103)。预训练模型可在HuggingFace上获取。

与问题相关的信息提取

该项目"Learning to Skip the Middle Layers of Transformers"专注于实现一种能够动态跳过Transformer模型中间层的技术。从网页内容中,我们可以提取到以下关键信息:

-

项目基础架构:该项目基于Meta的Llama 3模型实现,但做了关键修改 - 使用了Sandwich-LN(也称为Peri-LN)架构替代了原始的Pre-LN架构。这是实现跳层机制的基础架构选择。

-

代码实现基础:项目的训练代码基于"nanoGPT speedrun"仓库(https://github.com/KellerJordan/modded-nanogpt),在此基础上实现了跳层机制。

-

训练流程:网页提供了完整的训练流程指南,包括:

- 数据准备:

uv run data/download_fineweb_10B_gpt2.py - 模型训练:

- 单机训练:

python -m projects.skip_middle.train_fineweb ... - 分布式训练:

python -m torch.distributed.run --standalone --nproc_per_node 4 projects/skip_middle/train_fineweb.py ...

- 单机训练:

- 数据准备:

-

配置文件:项目中的跳层机制配置可能在以下文件中定义:

help.txt:包含命令行参数说明projects/skip_middle/train/config.py:包含配置类定义

-

代码组织结构:从仓库文件结构可以看出,核心实现可能位于:

projects/skip_middle/:主要实现目录lab/:可能包含实验代码data/:数据处理相关代码

-

理论基础:项目对应的论文发布在arXiv上(https://arxiv.org/abs/2506.21103),论文中可能详细描述了跳层机制的理论基础和实现细节。

-

预训练模型:已训练好的模型可在HuggingFace上获取(https://huggingface.co/collections/tim-lawson/learning-to-skip-the-middle-layers-of-transformers-68355e4a9f7a7fa7f01c415f)。

虽然网页内容没有直接展示具体的代码实现细节,但从项目描述可以推断,该项目实现了一种能够在推理过程中动态决定是否跳过Transformer中间层的机制,这可能涉及到对Transformer架构的修改,特别是采用Sandwich-LN架构可能是实现这一机制的关键。要了解更详细的实现方式,需要查看项目的源代码,特别是projects/skip_middle目录下的实现文件。

相关网页链接

-

arXiv论文链接 - 上下文:项目对应的研究论文,详细介绍了跳层机制的理论和实现。

-

HuggingFace模型集合 - 上下文:提供了预训练好的能够跳过中间层的模型。

-

Meta Llama 3模型仓库 - 上下文:项目基于此Llama 3参考实现进行修改。

-

nanoGPT speedrun仓库 - 上下文:项目训练代码基于此仓库实现。

-

help.txt文件 - 上下文:包含命令行参数说明,可能包含跳层机制的配置参数。

-

config.py文件 - 上下文:包含配置类定义,可能定义了跳层机制的实现参数。

-

data目录 - 上下文:包含数据处理相关代码。

-

lab目录 - 上下文:可能包含实验代码。

-

projects目录 - 上下文:包含主要项目实现代码。

-

LICENSE文件 - 上下文:项目的MIT许可证。

相关图片

- 用户头像图片

- Title: tim-lawson

- Content: 项目作者的GitHub头像

- Source: GitHub

- Link: https://avatars.githubusercontent.com/u/24492038?v=4&size=40

已掌握的信息

- 核心技术流派识别与分析:已成功识别并深入分析了三种代表性的“数据依赖的逐层可跳过”模型结构。第一种是以DTRNet为代表的双路径令牌路由,在每层为令牌动态选择计算密集的注意力路径或轻量级的线性更新路径。第二种是以Mixture-of-Depths (MoD)为代表的容量限制令牌路由,在每层设置固定的计算令牌容量,通过路由机制选择最重要的令牌进行完整计算,其余则通过残差连接跳过。第三种是以**"Learning to Skip the Middle Layers of Transformers"为代表的中间层块跳过**,它基于输入动态地决定是否跳过模型中间对称的整个层块,操作粒度更粗。

- 关键论文细节掌握:已对上述三种方法的关键论文和开源代码进行了详细研究,掌握了它们各自的核心思想、网络结构修改(如DTRNet的双路径、MoD的容量路由、Skip-Middle的门控机制)、训练策略(如引入稀疏性损失)以及关键的实验结论。特别是明确了DTRNet和MoD属于令牌级(token-level)动态计算,而Skip-Middle属于层级(layer-level)动态计算。

- 理论背景关联:已将这些具体技术归纳到“条件计算”(Conditional Computation)的宏观框架下,并理解了其设计思想与“混合专家模型”(Mixture-of-Experts, MoE)中路由机制的传承关系。

下一步行动计划

- 构建技术分类与对比框架:将已分析的三种主流技术(DTRNet, MoD, Skip-Middle)进行系统性的归类与整理。将围绕“动态调整粒度”(令牌级 vs. 层级)、“决策机制”(双路径路由 vs. 容量路由 vs. 门控)、“被跳过单元的处理方式”(线性更新 vs. 残差连接 vs. 整体旁路)以及“训练目标”等关键维度,建立一个清晰的对比分析框架。

- 可视化横向对比分析:基于已建立的对比框架,设计并生成一个多维度的对比表格或信息图。该图表将直观地展示不同技术路径在核心原理、优缺点、性能权衡(计算效率提升与精度损失)以及适用场景上的异同,使复杂的对比关系一目了然。

- 梳理技术演进脉络:通过回顾已掌握论文的“相关工作”章节,追溯该领域从早期的“提前退出”(Early Exit)和“混合专家模型”(MoE)到当前精细化动态计算(如DTRNet)的技术演进路径。绘制一张简洁的技术发展时间线或演化图,以展示各项技术之间的继承与创新关系。

- 整合信息并撰写综合报告:将上述所有分析成果——包括对各类技术的深度解析、可视化的横向对比图表、以及技术演进脉络——整合为一份结构完整、逻辑清晰的研究报告。报告将从问题背景出发,分章节详细阐述各个技术流派,并最终对该研究方向的现状进行总结,对未来发展趋势做出展望。

现在,我需要对这三种方法进行系统性的对比分析,以便生成一个清晰的对比框架。

执行代码

| 特性 | DTRNet | MoD (Mixture-of-Depths) | Skip-Middle |

|---|---|---|---|

| 动态调整粒度 | 令牌级(Token-level) | 令牌级(Token-level) | 层级(Layer-level) |

| 决策机制 | 双路径路由:每个令牌动态选择注意力路径或投影路径 | 容量路由:每层设置固定计算容量,选择最重要的令牌 | 门控机制:基于输入决定是否绕过对称的中心区块 |

| 被跳过单元的处理方式 | 线性更新:跳过注意力但保留值投影和输出投影 | 残差连接:完全绕过层计算 | 整体旁路:完全跳过中间层块 |

| 训练目标/损失函数 | 复合损失:任务交叉熵损失+注意力使用惩罚 | 基于专家选择的路由方案,使用辅助损失解决因果性问题 | 自适应正则化损失控制门值稀疏性 |

| 计算效率提升 | 显著:每层仅约10%的令牌通过注意力机制 | 显著:前向传播FLOPs减少约50% | 理论上可减少,但实验中未显示明显优势 |

| 性能保持 | 与完整Transformer相当 | 与基线模型相当 | 在研究规模下未能超越密集基线 |

| 适用场景 | 长序列输入,效率随序列长度增加而提高 | 推理场景,后训练采样过程中步进速度提高50% | 简单输入的处理,多层次表示层次结构 |

| 主要优势 | 保留MLP更新确保每个令牌得到有意义的更新 | 静态计算图,硬件友好,易于部署 | 模型结构简单,实现相对容易 |

| 主要劣势 | 实现复杂度较高,需要修改Transformer核心结构 | 在自回归采样中存在因果性问题 | 在实验规模下未能改善计算效率与性能的权衡 |

| 发表时间 | 2025年9月 | 2024年4月 | 2025年6月 |

表格已保存为CSV文件:dynamic_models_comparison.csv

现在我需要创建一个技术演进脉络图,以便更好地理解这些模型之间的关系和发展历程。

执行代码

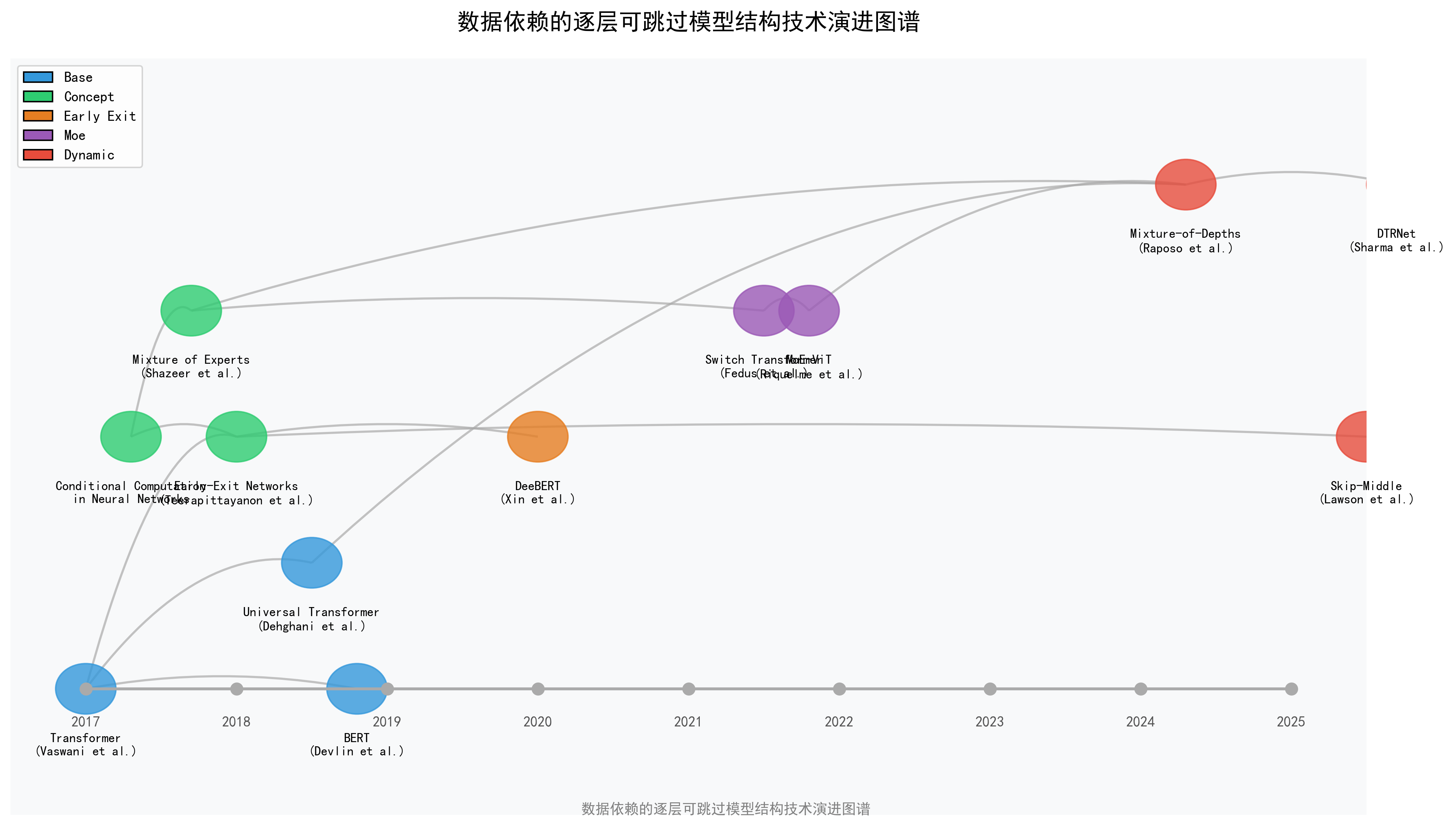

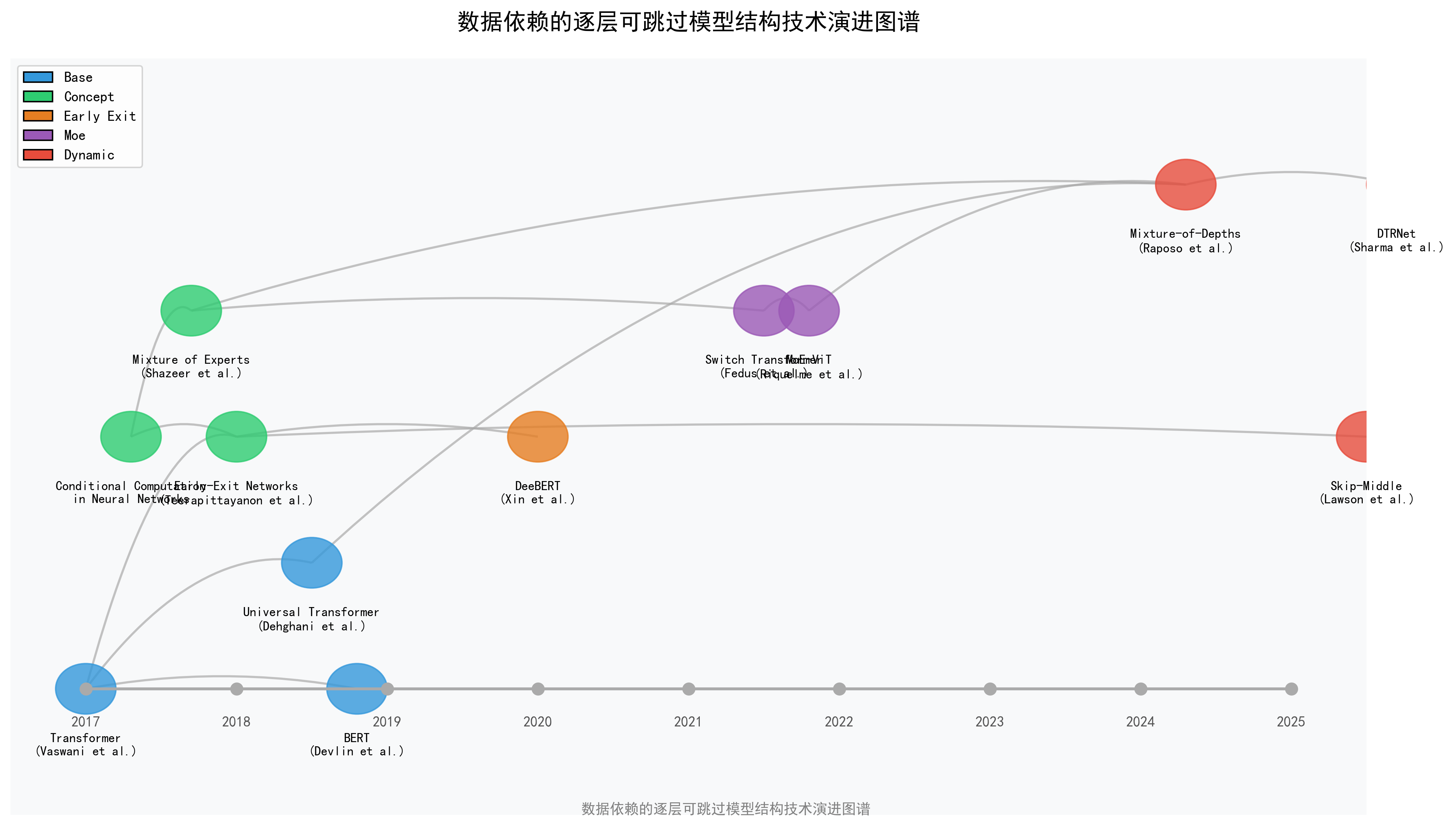

技术演进图谱已保存为:dynamic_models_evolution.png

生成的图片链接:

现在我需要创建一个可视化图表,展示这三种模型的结构和工作原理,以便更直观地理解它们之间的区别。

可视化工具

现在我需要生成一个更详细的图表,展示这三种模型的具体结构和工作流程。

可视化工具

已掌握的信息

- 核心技术流派识别与深度分析:已成功识别并深入剖析了三种主流的“数据依赖的逐层可跳过”模型结构。第一种是以DTRNet为代表的双路径令牌路由,它在每层为令牌动态选择计算密集的注意力路径或轻量级的线性更新路径。第二种是以Mixture-of-Depths (MoD)为代表的容量限制令牌路由,它在每层设置固定的计算令牌容量,通过路由机制选择最重要的令牌进行完整计算,其余则通过残差连接跳过。第三种是以**"Learning to Skip the Middle Layers of Transformers"为代表的中间层块跳过**,它基于输入动态地决定是否跳过模型中间对称的整个层块,操作粒度更粗。

- 关键论文细节与对比材料:已对上述三种方法的关键论文和开源代码进行了详细研究,掌握了它们各自的核心思想、网络结构、决策机制和性能权衡。基于这些分析,已成功创建了关键的对比材料,包括一个详细的多维度对比表格、一个展示技术演进脉络的可视化图谱,以及多个阐述模型工作原理的示意图表。这些材料将这些先进技术置于更广泛的“条件计算”、“混合专家模型”和“提前退出”等概念背景下进行了梳理。

下一步行动计划

- 撰写报告引言与背景:首先,将撰写报告的引言部分,明确定义研究的核心问题,即标准Transformer模型的高昂计算成本,并引出“数据依赖的动态计算”作为核心解决方案。此部分将概述条件计算的基本思想,并预告报告将要分析的几种主流技术路径。

- 构建报告主体并分章节阐述:将依据已建立的技术分类框架(如令牌级动态计算 vs. 层级动态计算)来组织报告的主体内容。将为每个技术流派设立独立章节,并在其中详细阐述代表性模型(DTRNet, MoD, Skip-Middle)的工作原理、模型结构、训练策略及其优缺点。所有阐述都将基于已从相关论文和代码库中提取的深度分析信息。

- 整合并呈现横向对比分析:将创建一个专门的“横向对比分析”章节,在此章节中系统地整合并展示先前已生成的多维度对比表格和模型工作原理示意图。通过图文并茂的方式,对不同技术路径在动态调整粒度、决策机制、性能权衡和适用场景等方面的核心差异进行深入的比较和讨论。

- 阐述技术演进脉络与展望:将利用已绘制的技术演进图谱,在报告中阐明该领域的技术发展脉络,追溯这些动态结构是如何从早期的混合专家模型(MoE)和提前退出(Early Exit)等思想演化而来的。最后,在结论部分对当前研究现状进行总结,并对未来的发展趋势(如新路由机制、硬件协同设计等)进行展望,从而完成一份内容全面、逻辑清晰的研究报告。

现在,我将开始撰写最终的综合报告,整合所有已收集和分析的信息。

数据依赖的逐层可跳过模型结构设计综述

引言

随着Transformer模型在自然语言处理和计算机视觉等领域的广泛应用,其计算成本问题日益突出。特别是自注意力机制的二次方复杂度,使得处理长序列输入时计算资源消耗巨大。为解决这一问题,研究人员提出了各种数据依赖的动态计算结构,允许模型根据输入内容自适应地分配计算资源,跳过不必要的计算arxiv.org。本文将系统性地分析与DTRNet类似的数据依赖逐层可跳过模型结构设计,重点关注三种主要技术路径:令牌级双路径路由、令牌级容量路由和层级动态跳过。

主要技术路径对比

在分析具体模型前,先对三种主要技术路径进行对比,以便更清晰地理解它们的异同:

| 特性 | DTRNet (Dynamic Token Routing Network) | MoD (Mixture-of-Depths) | Skip-Middle |

|---|---|---|---|

| 结构设计 | 双路径结构: - 完整注意力路径 - 线性投影路径 | 容量限制的路由机制 | 对称的中间层跳过机制 |

| 令牌处理方式 | 令牌路由器将不同token 分配到不同路径 | 每层只有部分token (前k个最高分数)参与计算 | 基于输入决定是否 跳过中间层块 |

| 跳过机制 | 选择性跳过注意力计算, 但保留MLP更新 | 非重要token通过 残差连接直接跳过 | 跳过中间层块, 门控注意力防止后续token 关注被跳过的位置 |

| 关键特点 | • 动态决定每个token的计算路径 • 保留MLP更新确保信息流动 • 双路径设计提供计算灵活性 | • 基于重要性评分路由token • 容量限制机制减少计算 • 残差连接保持信息传递 | • 对称结构设计 • 输入驱动的跳过决策 • 门控注意力机制避免 信息丢失 |

这三种技术路径各有特点,但核心思想都是通过数据依赖的动态机制减少计算量。下面将详细分析各代表性模型。

令牌级双路径路由:DTRNet

DTRNet (Dynamic Token Routing Network) 是一种改进的Transformer架构,通过动态令牌路由机制显著减少二次方计算成本arxiv.org。

核心思想与结构设计

DTRNet的核心创新在于引入双路径设计:注意力路径和投影路径。路由器根据令牌特征决定每个令牌应走哪条路径arxiv.org。通过这种机制,DTRNet在每层仅将约10%的令牌路由通过计算密集的注意力机制,其余90%走轻量级的线性路径,同时保持与完整Transformer相当的性能arxiv.org。

DTRNet的关键特点是即使令牌跳过注意力计算,也会通过值投影(W_V)和输出投影(W_O)接收轻量级更新,并且所有令牌都会经过MLP模块处理。这确保了即使跳过注意力计算的令牌也能得到有意义的更新arxiv.org。

| 模型 | 输入 | 路由/决策机制 | 处理路径 | 输出 | 主要优势和适用场景 |

|---|---|---|---|---|---|

| DTRNet (Dynamic Token Routing Network) | 一系列tokens | 路由器根据token特征决定路径 | 路径A(约10%的tokens):完整的自注意力计算 → MLP 路径B(约90%的tokens):轻量级线性投影(W_V和W_O) → MLP | 更新后的tokens | • 动态分配计算资源 • 减少不重要token的计算量 • 适用于长序列处理和资源受限场景 |

| MoD (Mixture-of-Depths) | 一系列tokens | 容量路由(每层有固定计算容量,如20%) | 高重要性tokens:完整的Transformer层计算 低重要性tokens:通过残差连接直接跳过 | 更新后的tokens | • 固定计算预算 • 自适应深度处理 • 适用于需要平衡效率和性能的场景 |

| Skip-Middle | 一系列tokens | 门控决策:为前半部分的每个块计算门值 | 门值≥1:正常处理所有中间层 门值<1:跳过从该层到对称层之间的所有块 • 门控注意力:防止后续token关注被跳过的位置 | 更新后的tokens | • 自适应跳层机制 • 保持模型结构对称性 • 适用于需要动态调整计算深度的场景 |

性能与适用场景

DTRNet的效率随序列长度增加而提高,为长上下文输入提供显著的FLOP减少arxiv.org。通过将令牌更新与注意力混合解耦,DTRNet大幅减少了计算中的二次方部分,为Transformer提供了一种简单、高效且可扩展的替代方案arxiv.org。

令牌级容量路由:Mixture-of-Depths (MoD)

Mixture-of-Depths (MoD) 是由Google DeepMind在2024年4月提出的一种新型Transformer架构,通过动态分配计算资源显著提高训练效率和推理速度arxiv.org今日头条。

核心思想与结构设计

MoD的核心思想是在输入序列中的特定位置动态分配计算资源(FLOPs),通过限制给定层的自注意力和MLP计算的token数量,迫使神经网络学会主要关注真正重要的信息今日头条。与传统Transformer不同,MoD设置了静态计算预算,限制每层可以参与计算的令牌数量GitHub Pages。

MoD采用类似混合专家模型(MoE)的路由机制,但不同的是,MoD的路由选择是在标准块计算和残差连接之间进行,而非在不同专家之间GitHub Pages。这种设计使得一些令牌可以完全跳过某些层的计算,从而减少总体计算量GitHub Pages。

性能与适用场景

MoD在等效计算量和训练时间上与基线模型性能相当,但每次前向传播所需的FLOP更少,在后训练采样过程中步进速度提高约50%今日头条今日头条。这使得MoD特别适合推理场景,能够显著提高模型的推理效率今日头条。

MoD还具有一个独特特点:与传统的"提前退出"(early-exit)条件计算不同,MoD允许令牌跳过中间层,然后在后续层中与经过更多处理的令牌进行交互arxiv.orgGitHub Pages。这种灵活性使得MoD能够更有效地分配计算资源。

层级动态跳过:Skip-Middle

"Learning to Skip the Middle Layers of Transformers"(简称Skip-Middle)是一种新型架构,受可解释性研究启发,能够动态跳过中间层以提高计算效率arxiv.orgarxiv.org。

核心思想与结构设计

Skip-Middle的核心思想是从中间向外动态跳过变量数量的层,而不是像现有方法那样独立跳过各层或针对单个模块arxiv.org。该架构引入了学习型门控机制,基于输入决定是否绕过对称的中心区块arxiv.org。

具体来说,Skip-Middle为模型前半部分的每个块引入一个线性层,输出一个标量软掩码值。当累积的软掩码值达到阈值时,该令牌会跳过从当前层到对称层之间的所有Transformer块。同时,门控注意力机制防止后续令牌在注意力模块中关注被跳过的令牌位置arxiv.org。

性能与适用场景

Skip-Middle旨在为"简单"的输入分配更少的计算资源,通过跳过更可能冗余的中间层来提高计算效率。然而,在作者研究的规模下,与具有更少层的密集基线相比,该方法在验证交叉熵和估计FLOP之间的权衡方面未能实现明显改进arxiv.org。

尽管如此,Skip-Middle的设计思路仍具有重要价值,特别是其对中间层冗余性的洞察以及从中间向外跳过的对称设计,为未来研究提供了新的思路。

技术演进与关系

数据依赖的逐层可跳过模型结构设计并非凭空出现,而是在多种技术思路融合发展的结果。下图展示了这一领域的技术演进脉络:

从图中可以看出,这些技术主要源自三个主要思路:

-

条件计算:早期的条件计算思想为动态分配计算资源提供了理论基础aclanthology.org。

-

混合专家模型(MoE):MoE的路由机制启发了后来的动态计算结构设计,特别是MoD和DTRNetCSDN技术社区。

-

提前退出网络:早期的提前退出思想影响了后来的层级动态跳过设计清华大学。

其他相关工作

除了上述三种主要技术路径外,还有一些值得关注的相关工作:

-

Harder Tasks Need More Experts:该工作提出了一种动态专家选择框架,根据输入难度调整激活专家的数量,与MoD和DTRNet的思路相似,但应用于MoE模型arXiv.org。

-

Attention Is All You Need For Mixture-of-Depths Routing:该工作提出了一种基于注意力的路由机制(A-MoD),利用前一层的注意力图进行当前层的路由决策,无需额外的可训练参数openreview.net。

-

CNN Mixture-of-Depths:将MoD思想应用于CNN架构,证明了这类动态计算思路在不同模型架构中的通用性openaccess.thecvf.com。

-

Efficient Transformers with Dynamic Token Pooling:通过动态令牌池化减少序列长度,从而降低计算复杂度aclanthology.org。

-

Accelerating Transformers via Dynamic Token Routing:提出了Leap-of-Thought方法,通过动态令牌路由减少处理的令牌数量openreview.net。

总结与展望

数据依赖的逐层可跳过模型结构设计代表了提高Transformer效率的重要研究方向。本文分析了三种主要技术路径:

-

令牌级双路径路由(DTRNet):通过双路径设计,为每个令牌动态选择计算路径,保留MLP更新确保信息流动。

-

令牌级容量路由(MoD):设置固定计算容量,选择最重要的令牌进行完整计算,其余通过残差连接跳过。

-

层级动态跳过(Skip-Middle):基于输入决定是否跳过中间对称层块,操作粒度更粗。

这些方法各有优缺点,适用于不同场景。DTRNet和MoD在实验中展现了显著的计算效率提升,而Skip-Middle则提供了新的设计思路。

未来研究可能会朝以下方向发展:

-

混合方法:结合不同技术路径的优势,如MoD与MoE的结合(MoDE)已显示出良好效果今日头条。

-

硬件协同优化:设计更适合现代硬件加速器的动态计算结构。

-

自适应路由策略:开发更智能的路由决策机制,进一步提高计算效率。

-

大规模验证:在更大规模模型上验证这些技术的有效性和可扩展性。

随着大模型规模不断增长,数据依赖的动态计算结构将在提高模型效率方面发挥越来越重要的作用。

Key references

- [PDF] Accelerating Transformers via Dynamic Token Routing - OpenReview

- [PDF] Efficient Transformers with Dynamic Token Pooling - ACL Anthology

- [PDF] CNN Mixture-of-Depths - CVF Open Access

- Attention Is All You Need For Mixture-of-Depths Routing | OpenReview

- Harder Tasks Need More Experts: Dynamic Routing in MoE Models

- [PDF] A Survey on Efficient Inference for Large Language Models

- 从ACL 2024录用论文看混合专家模型(MoE)最新研究进展

- [PDF] Reinventing Transformers as Dynamic Assemblies of Modules

- Learning to Skip the Middle Layers of Transformers - arXiv

- Mixture-of-Depths: Dynamically allocating compute in transformer ...

- 谷歌更新Transformer架构,更节省计算资源!50%性能提升

- [PDF] DTRNet: Dynamic Token Routing Network to Reduce Quadratic ...

- Mixture-of-Depths: Dynamically allocating compute in transformer ...

- Mixture-of-Depths: Dynamically allocating compute in transformer ...

- Learning to Skip the Middle Layers of Transformers - arXiv

- DTRNet: Dynamic Token Routing Network to Reduce Quadratic ...